Elektroneja, ytimiä ja monen kappaleen ongelma

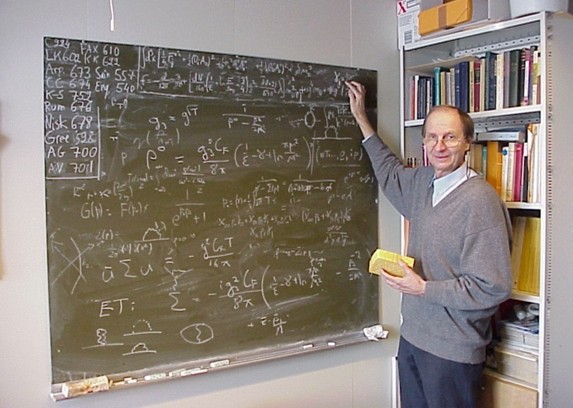

Olemme tulleet noin sata vuotta kvanttimekaniikan synnystä ja kiivaan alkuvaiheen kehityksen jälkeen teorian perusteet ovat olleet likimain muuttumattomia. Heti alkumetreillä todettiin, että muutaman symbolin Schrödingerin yhtälö kuvaa hyvin merkittävää osaa maailmasta, mutta sen ratkaiseminen...